Dzięki chmurze moc superkomputera jest dostępna dla każdej firmy. Tylko obliczenia o wysokiej wydajności umożliwiają obliczenia bardzo złożonych analiz i symulacji.

Podczas gdy big data i uczenie maszynowe są na ustach wszystkich, obliczenia o wysokiej wydajności (HPC) mają tendencję do prowadzenia mrocznej egzystencji wśród ogółu społeczeństwa – niesłusznie.

„Obliczenia o wysokiej wydajności umożliwiły przede wszystkim najnowsze osiągnięcia i sukcesy w dziedzinie uczenia maszynowego i dużych zbiorów danych” – powiedzieli naukowcy z Instytutu Algorytmów i Informatyki Naukowej im. Fraunhofera w Sankt Augustin.

BullSequana XH2000: Dzięki superkomputerowi hybrydowemu można organizować obciążenia między lokalnymi, publicznymi i prywatnymi środowiskami chmury. (Źródło: Atos) Rozwiązania HPC wspierają złożone analizy i symulacje z wykorzystaniem obliczeń o wysokiej wydajności, tj. w szczególności poprzez ogromną moc obliczeniową i wysoką tolerancję błędów, co jest trudne do osiągnięcia przy klasycznych stacjach roboczych i serwerach w firmie.

Szybkość HPC zależy od konfiguracji systemu komputerowego, klastrów i procesorów, pamięci, sieci, oprogramowania i systemu operacyjnego, aplikacji i złożoności zadań. 500 najszybszych komputerów na świecie zapewnia obecnie co najmniej 1 PetaFLOPS, czyli biliard operacji arytmetycznych na sekundę.

Według stowarzyszenia cyfrowego Bitkom, obliczenia o wysokiej wydajności są niezbędne dla konkurencyjności nauki i przemysłu. Nowoczesne badania i rozwój byłyby nie do pomyślenia bez szczegółowych symulacji. Dotyczy to również kluczowych obszarów niemieckiej gospodarki, co podkreśla Bitkom. Niezależnie od tego, czy chodzi o urządzenia elektroniczne, samochody, samoloty, nowoczesne leki czy innowacyjne procedury chirurgiczne, wszystkie one opierają się na wynikach symulacji.

Na przykład operator sieci przesyłowej Tennet OSP pokazuje, jak w praktyce można wykorzystać obliczenia dużej mocy. Specjalny system komputerowy został opracowany wspólnie z ekspertami z Centrum Superkomputerowego Jülich (JSC). Ma on pomóc w dostosowaniu sieci energetycznej, która rozwijała się przez dziesięciolecia, do wymogów transformacji energetycznej. Do rozbudowy operator sieci wykorzystuje komputerowe symulacje przepływów obciążenia w sieci elektroenergetycznej, które w nowym systemie można przyspieszyć ponad 30-krotnie.

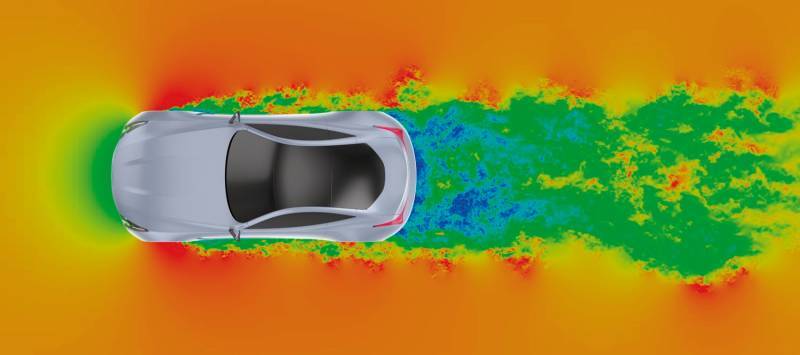

Jako usługa: Altair i Oracle oferują HPC w chmurze do wykonywania numerycznych obliczeń przepływu na żądanie, np. do symulacji aerodynamiki zewnętrznej. (Źródło: Altair Engineering GmbH) Tennet TSO, z siedzibą w Bayreuth, jest jedną z czterech firm w Niemczech odpowiedzialnych za działanie krajowej sieci elektroenergetycznej. W ramach trzyletniej współpracy z Tennet eksperci JSC opracowali hybrydowy system komputerowy: „Smart Performance Cluster” jest specjalnie dostosowany do aplikacji wykorzystywanych przez firmę i udostępnia zasoby dla oprogramowania Windows i Linux w ramach jednego interfejsu.

„Dzięki nowo opracowanemu systemowi jesteśmy w stanie wykonywać równolegle liczne obliczenia. Daje to więcej czasu na analizę wyników obliczeń w innych wymiarach i zdobycie nowej wiedzy. Ponadto niektóre obliczenia były możliwe dopiero wraz z wprowadzeniem nowego systemu, dlatego współpracę z JSC oceniamy jako niezwykle udaną – wyjaśnia Stefan Schuh, odpowiedzialny za współpracę ze strony Tennet.

W przypadku poprzedniej technologii - oprogramowanie symulacyjne działało na klasycznych serwerach - ogromny wzrost wymaganej do tego mocy obliczeniowej nie byłby możliwy, również ze względu na złożoność niemieckiego systemu energetycznego, który ogromnie wzrósł w trakcie transformacji energetycznej .

Wspólnie z dostawcą usług IT i twórcami oprogramowania symulacyjnego eksperci JSC dostosowali aplikacje Tennet do przetwarzania równoległego przez dużą liczbę procesorów i dostosowali komputer równoległy z inteligentnym zarządzaniem zasobami do wymagań firmy Bayreuth, dzięki czemu symulacje są skoordynowane i znacznie przyspieszają inne aplikacje.

Superkomputery w liczbach W Instytucie Technologii w Karlsruhe (KIT) wysokowydajny komputer badawczy umożliwia naukowcom pracę nad złożonymi problemami aplikacyjnymi. Nazwa: ForHLR II W eksploatacji: od 2016 r. Koszty: 8,5 mln euro Węzły: 1173 (1152 z 64 gigabajtami każdy, 21 z 1 terabajtem każdy) Rdzenie obliczeniowe: ponad 24 000 Wydajność: przy podstawowej szybkości procesora 939 TeraFLOPS, z turbodoładowaniem ponad 1 PetaFLOPS Pamięć główna: 93 terabajty Ekran: 15 m2 Ranking: 442 miejsce na liście 500 najlepszych superkomputerów (stan na lipiec 2018) Następca: w budowie od 2019 do 2021

W Instytucie Technologii w Karlsruhe (KIT) wysokowydajny komputer badawczy umożliwia naukowcom pracę nad złożonymi problemami aplikacyjnymi.

Nazwa: ForHLR II

W eksploatacji: od 2016 r.

Koszt: 8,5 mln euro

Węzły: 1173 (1152 z 64 gigabajtami każdy, 21 z 1 terabajtem każdy)

Rdzenie obliczeniowe: ponad 24 000

Wydajność: przy podstawowej szybkości procesora wynoszącej 939 TeraFLOPS, z turbodoładowaniem powyżej 1 PetaFLOPS

Pamięć główna: 93 terabajty

Ekran: 15 m2

Ranking: 442 miejsce na liście 500 najlepszych superkomputerów (stan na lipiec 2018)

Następca: w budowie od 2019 do 2021

Leave a Comment